Luego que hemos entrado a lo que vendría a ser la estadística inferencial y el valor p, sería importante tomar en cuenta cuáles son los típicos errores que se pueden encontrar en estadística.

En el post de hoy, definiremos, como siempre de manera sencilla y con ejemplos, los típicos errores que existen en estadística inferencial. En ese caso, aprenderemos qué es el error tipo 1 y el error tipo 2.

Espero que estén preparados, así que abrochen sus cinturones que aquí vamos. Antes de empezar, les recomiendo que hagan un viaje por su memoria de largo plazo y recuerden la prueba de hipótesis. Si es que no quieren hacer ese maravilloso viaje, ¡no hay problema! Pueden ir al post anterior sobre estadística inferencial y ahí encontrarán información sobre qué es una prueba de hipótesis. Como verán, a partir de ahora algunos posts requerirán de conocimientos previos que pueden intentar recordarlos, o ir a los anteriores posts para buscar la información.

Recuerden, siempre que hay algo que no quedó claro pueden dejar un comentario en el blog y encantado de poder abordarlo con ustedes. Bueno, vamos a lo nuestro.

El error tipo, error alfa o falso positivo, ocurre cuando el investigador rechaza la primera hipótesis (o hipótesis nula), (que es por ejemplo, cuando se dice que dos grupos son iguales y no hay diferencias entre sus promedios). Esto, también es llamado falso positivo porque estamos diciendo que hay diferencias entre dos grupos cuando en realidad no las hay. Vamos a un ejemplo diferente que el del post pasado para hacer esto mucho más claro, ¿Les parece?

Ustedes hacen una investigación para conocer si existe relación entre la percepción de soporte social de los amigos hacia los adolescentes y el autoestima general de los púberes. En otras palabras, queremos saber si estas variables se relacionan, donde a mayor autoestima mayor soporte social percibido y viceversa. Para ello, necesitamos plantear hipótesis que serían las siguientes:

1) No existe relación entre soporte social percibido y autoestima en adolescentes.

2) Existe una relación positiva entre soporte social percibido y autoestima en adolescentes.

Muy bien, entonces ya tenemos nuestras hipótesis, les tomamos unos cuestionarios de autoestima y de soporte social percibido a 500 jóvenes, metemos toda la información a la computadora, hacemos los análisis y ¡Bum! sale que el valor p es menor a 5% entonces se puede rechazar la primera hipótesis. ¡Genial!

Sin embargo, aquí es cuando aparece el error tipo 1 o falso positivo ocurre. Nosotros hemos rechazado la primera (que no hay relación entre ambas variables) cuando de verdad no la había. ¿Cómo sabemos que no las habían? Porque un amigo/a que es un genio/a en estadística realizó análisis más complejos y se percató de este detalle. Pero no desesperen, eventualmente esos análisis más complejos también serán explicados e incluso mencionados al final de este post.

Espero que estén aún aquí conmigo, como ven, no es tan difícil como suena. ¡Vamos al otro tipo de error!

El error tipo II, error tipo beta o falso negativo, se comete cuando aceptamos la primera hipótesis, y decimos que no hay diferencias entre grupos, o no hay relación entre dos variables psicológicas, cuando de verdad sí la hay.

Vamos al mismo ejemplo que utilizamos anteriormente. Meses después, nos quedamos con la duda sobre la relación entre percepción de soporte social de los pares en un grupo de adolescentes y el autoestima de los púberes. Entonces, volvimos a hacer la investigación y planteamos las mismas hipótesis:

1) No existe relación entre soporte social percibido y autoestima en adolescentes.

2) Existe una relación positiva entre soporte social percibido y autoestima en adolescentes.

Pero esta vez, le aplicamos los cuestionarios a 1000 adolescentes de 10 colegios de Perú. Recolectamos la información, la digitamos, analizamos y ¡Bam! la significación o valor p salió 10% o 0.10 en SPSS (ver post sobre estadística inferencial para ver qué significa esto).

En ese caso, aceptamos la primera hipótesis (o hipótesis nula, ver comentario del post de estadística inferencial) que dice que no hay relación entre soporte social percibido y autoestima.

Meses después nos encontramos con un compañero o colega investigador y nos cuenta que él/ella hizo el mismo estudio con las mismas personas y encontró que sí había relación entre las variables. En sencillo, hemos cometido un error tipo II, porque dijimos que no había relación entre dos variables cuando en realidad sí la había.

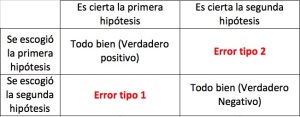

Entiendo que esto puede ser un poco engorroso y muchísima información, pero no se preocupen. Para facilitar la explicación pondré una tabla resumen al final del post que pueda redondear lo que hemos visto aquí.

¿Por qué ocurren estos tipos de errores? Por diversas razones, puede ser la manera de cómo se ha recolectado la información, el diseño de los cuestionarios, el momento en que la persona tomó las pruebas (justo aplicó las pruebas cuando los jóvenes habían desaprobado un examen o se habían peleado con un amigo, lo cual puede afectar su autoestima y/o autoestima) entre otras cosas.

Lo bueno, es que hay maneras de darnos cuenta cuándo cometemos este tipo de errores. Existen técnicas más complejas como son el tamaño del efecto y el poder estadístico que nos permiten tener indicios si es que hay un sesgo en nuestros resultados y estamos cometiendo un error. Otras técnicas muy utilizadas son los intervalos de confianza y el bootstrapping. En este post no veremos estas técnicas porque no es el objetivo del mismo. Sin embargo, más adelante (incluso en el siguiente post) prestaremos atención a los intervalos de confianza.

Ojo, pestaña y ceja, que les haya presentado estos dos errores no quiere decir que sean los únicos que existen. Hay autores que plantean que hay 4 errores típicos. Los que están interesados en ellos pueden ir a la parte de comentarios que ahí serán explicados.

¡Bueno! Creo que ha sido bastante por hoy. Tal como les mencioné líneas atrás, el siguiente post tratará sobre otra manera de determinar si un valor es significativo o no. Para el siguiente post, abordaremos los intervalos de confianza y su uso.

Si han llegado hasta acá, ¡Los felicito! ¡Muy buen trabajo! ¡Me alegro mucho! Espero que esto no esté siendo muy tedioso para ustedes y que la lectura esté siendo rápida y clara. Recuerden que siempre pueden dejar preguntas, comentarios sobre cualquier tema en general y encantado de respondérselas. Sin más que decir, ¡Nos vemos en el siguiente post! ¡Buenas vibras a todos! ¡Hasta la vista!

Tabla resumen de error tipo 1 y error tipo 2

Bibliografía recomendada:

Lieberman, M., & Cuninghma, W. (2009). Type I and type II error concerns in FMRI research: re-balancing the scale. SCAN, 4, 423 – 428. doi:10.1093/scan/nsp052

En este comentario, agregaré información sobre los otros dos tipos de errores. Según Andrew Gelman, además del error tipo 1 y el error tipo 2 existe el error “S” y el error “M”.

El error “S” es cuando por ejemplo queremos comparar los promedios de dos grupos y tenemos la hipótesis que el grupo 1 obtendrá un mayor promedio que el grupo 2. Luego de hacer el análisis nos damos cuenta que era al revés y el grupo 2, tenía un mayor promedio que el grupo 1. Ese, según Gelman, es el error “S”.

Por otro lado, el error “M”, está relacionado con la magnitud del efecto, Este error se da cuando concluimos que el efecto es más grande lo que realmente es. Este error será visto con mayor profundidad en el post sobre tamaño del efecto.

¡Hasta la vista a todos! ¡Buenas vibras!

LikeLike

Hola JC, soy tu fan, aunque soy tan taba que incluso con tus explicaciones me es dificil entender. Tengo muchas preguntas, aunque no se en que post sea mas pertinente colgarlo, lo pongo aca porque hasta aca he leido y entendido. Tengo para mi tesis una muestra de entre 30 y 40 personas (aun estoy transcribiendo y sacando resultados, espero llegar a 35 minimo) y a todos les tomaron 2 tests de Funcion Reflectiva Paterna, uno antes de una intervencion y otro despues de la intervencion. Obviamente mi hipotesis es que las dos medias son diferentes, es mas, creo que el test post intervencion dio resultados mas altos en los miembros de mi muestra. Al menos la intervencion intenta ayudarlos en mejorar su Funcion Reflectiva. Mi gran duda era que estadistico uso para comparar las medias? T-Student? aun no se si la distribucion es normal, pero me han dicho que igual se puede asumir normalidad de la poblacion por algo, un concepto que no me acuerdo el nombre. La muestra total son como 500 personas intevenidas desde hace anhos, pero solo en los ultimos 10 anhos se toma esta prueba asi que nunca podremos saber si la distribucion es normal.

Por ultimo, sabes donde puedo leer en ingles (para citarlo) eso de si la investigación es descriptiva, el diseño (experimental o lo otro). Eso que leiamos en Hernández, Fernández & Baptista (2006).

LikeLike

Hola Maria Paz, gracias por dejar tu comentario.

En este caso, tendrías que usar T-student pero para muestras relacionadas. (Esta justo abajo de muestras independientes en el SPSS). La ruta es: Analizar/Comparar medias/T para muestras relacionadas.

Mira, puedes asumir normalidad porque seguro la asimetría y la curtosis no deben ser muy altas (mira los posts de normalidad y cuando una distribución no es normal y ahí tendrás la información), asume normalidad, no hay problema. Los estadísticos de asimetría y curtosis los puedes encontrar en /analizar/estadísticos descriptivos/frecuencias/opciones/curtosis y asimetría. Si usas un SPSS en inglés es Kurtosis y Skewness.

Sobre la fuente bibliográfica puedes usar Hernadez, Fernadez & Baptista, 2010 (la versión del 2006 también puede servirte).

Sino, en general libros de metodología de investigación pueden servirte. Pero si fuera tu, me inclino por estos que son los más amables para leer.

Ojo, pestaña y ceja, no te espantes si no te sale significativa la diferencia, por ser una muestra pequeña puede que eso pase, pero eso siempre se puede comentar en limitaciones.

Espero que esto te haya ayudado.

¡Buenas vibras!

LikeLike

Gracias millones!!! Me recontra ayudo

LikeLike

Pingback: Cerveza, estadística y la t-student | Estadística para todos, hecho por un psicólogo

Pingback: Gonzalo apoya la aditividad: Los 4 supuestos de la regresion lineal | Stats SOS